Artigos

Artigos

Grid Computing

Grid Computing

- Framework para Desenvolvimento de Aplicativos

- Application Express

- Business Intelligence

- Cloud Computing

- Communications

- Desempenho e Disponibilidade de Banco de dados

- Data Warehousing

- .NET

- Linguagens de Programação Dinâmica

- Embedded

- Arquitetura Enterprise

- Enterprise Management

- Grid Computing

- Identidade e Segurança

- Java

- Linux

- Service-Oriented Architecture

- SQL & PL/SQL

- Virtualização

- Sistemas

Oracle Grid Infrastructure 12cR1 - Parte 6 - Instalando o Grid Infrastructure

Por Victor Armbrust

Postado em Janeiro 2014

Indice

1. Oracle Grid Infrastructure 12cR1 - Parte 1 - Visão Geral e Novos Recursos

2. Oracle Grid Infrastructure 12cR1 - Parte 2 - Configurando o Sistema Operacional

3. Oracle Grid Infrastructure 12cR1 - Parte 3 - Pré-Requisitos do Sistema Operacional

4. Oracle Grid Infrastructure 12cR1 - Parte 4 - Configurando DNS

5. Oracle Grid Infrastructure 12cR1 - Parte 5 - Pré-Requisitos do Grid Infrastructure

6. Oracle Grid Infrastructure 12cR1 - Parte 6 - Instalando o Grid Infrastructure

7. Oracle Grid Infrastructure 12cR1 - Parte 7 - Instalando o Database Software

8. Oracle Grid Infrastructure 12cR1 - Parte 8 - Criando Diskgroups no ASM

9. Oracle Grid Infrastructure 12cR1 - Parte 9 - Criando o Database

10.Oracle Grid Infrastructure 12cR1 - Parte 10 - Validações Finais

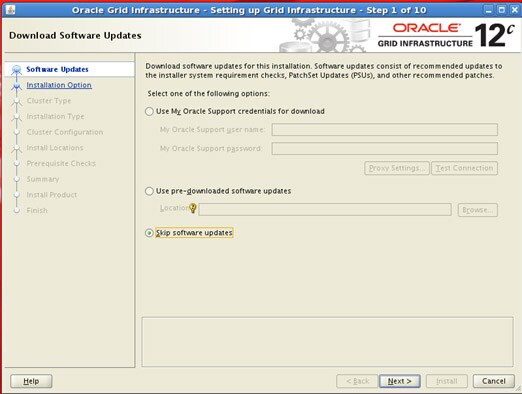

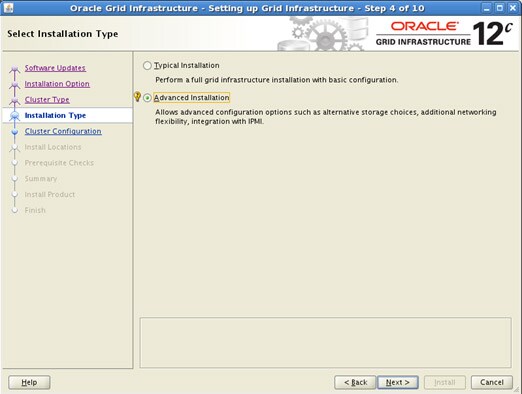

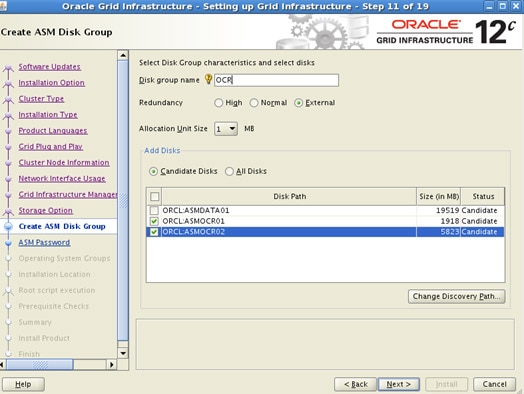

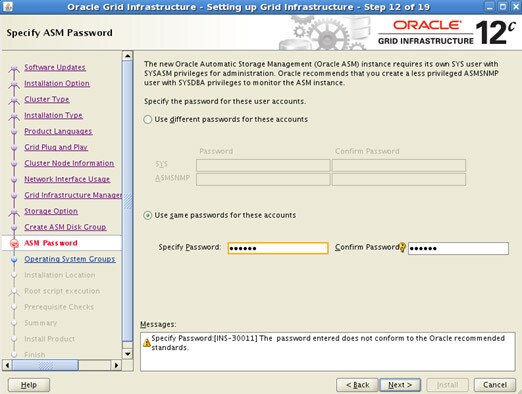

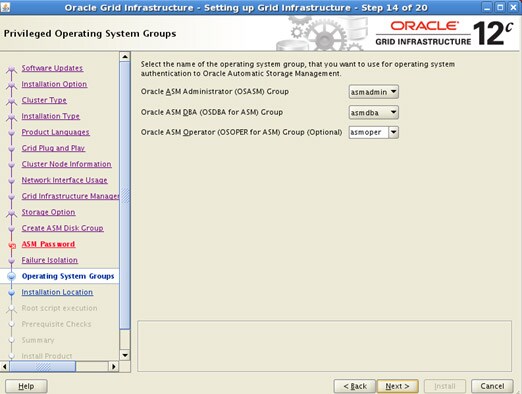

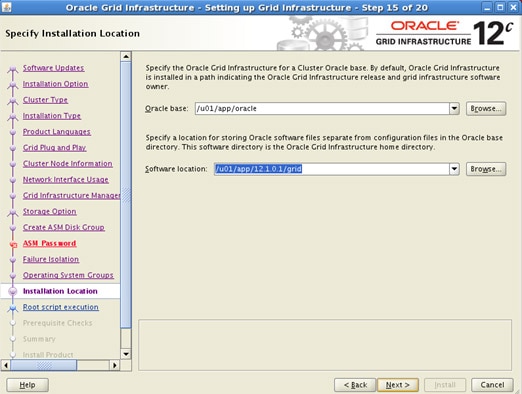

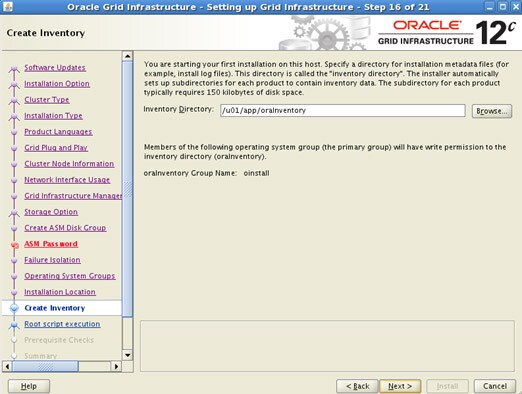

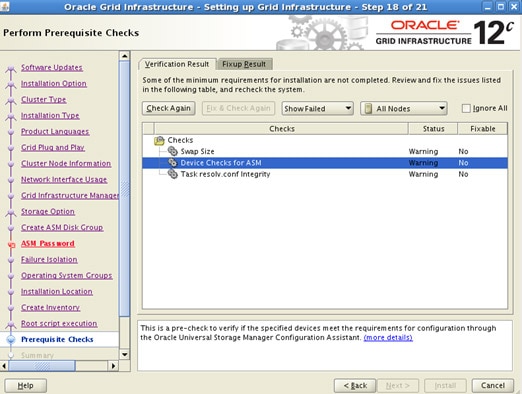

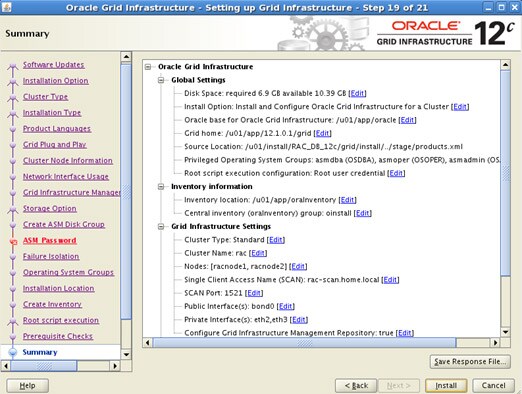

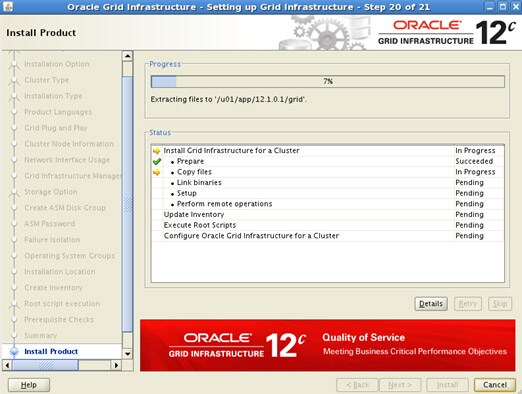

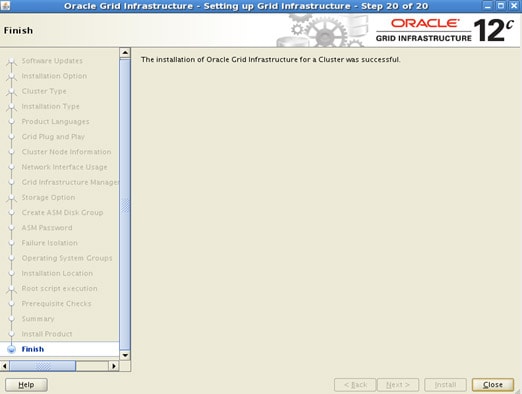

Após todos os pré-requisitos configurados e ajustados, o próximo passo é instalar o Grid Infrastructure.

Procedimento de instalação:

# su – grid Iniciar o VNC: # vncserver :1 (conectar ao VNCSERVER na porta 1) # cd /u01/install/RAC_DB_12c/grid/runInstaller.sh

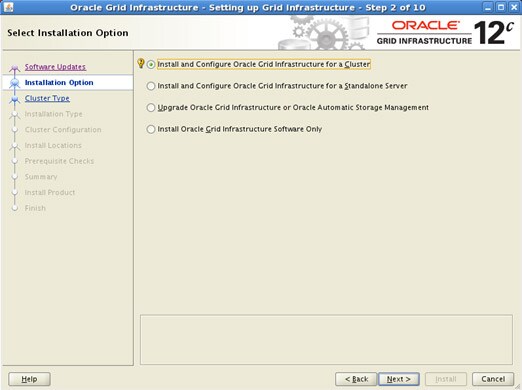

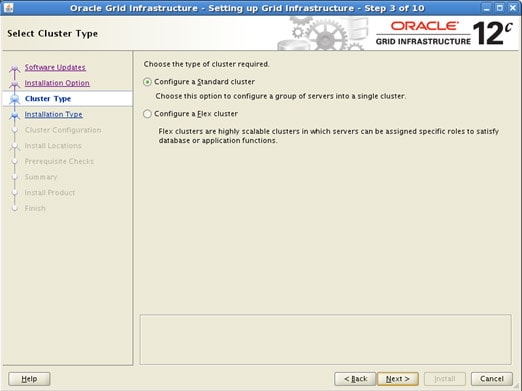

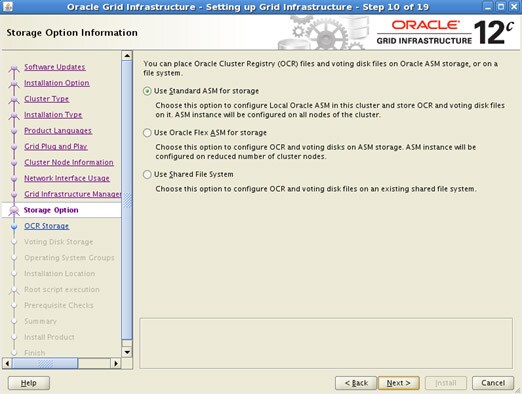

A Instalação será feita para apenas um Standard Cluster. Mais a frente o cluster será reconfigurado para Flex Cluster com Flex ASM e com a adição de Leaf Nodes.

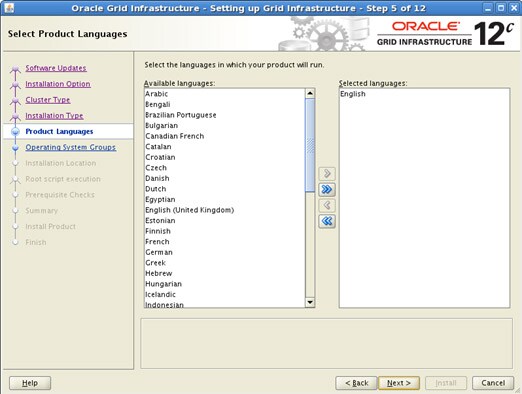

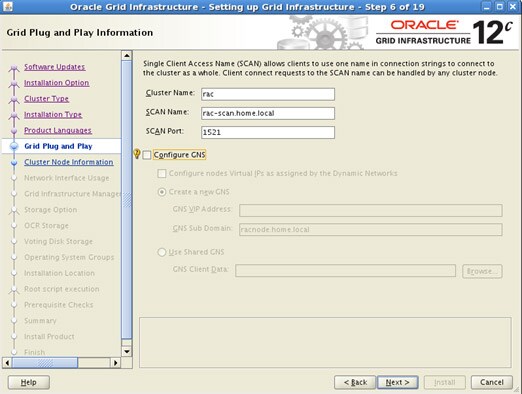

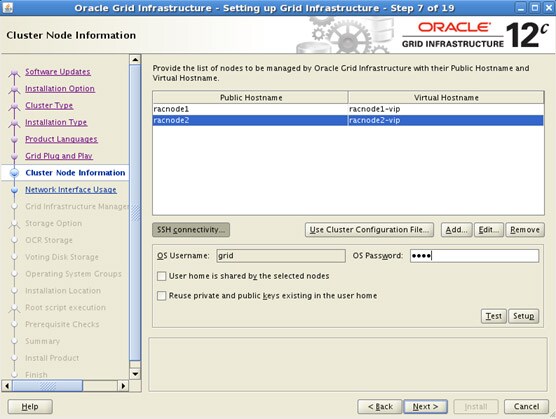

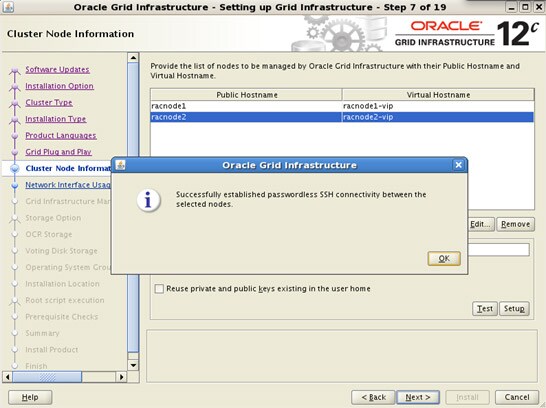

As proximas telas servem apenas como exemplo para uma instalação qualquer, trocando apenas nomes de NODES e nome do CLUSTER

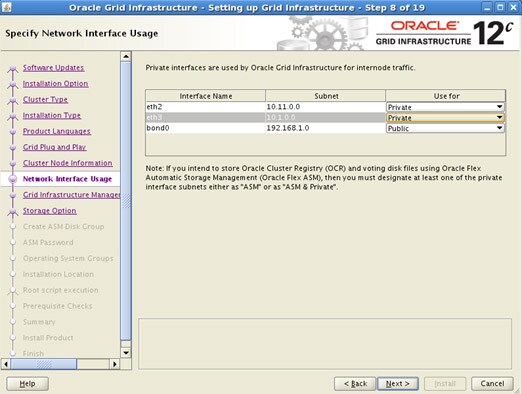

Manter as placas de interconnect como ASM & Private. Isso será utilizado mais adiante.

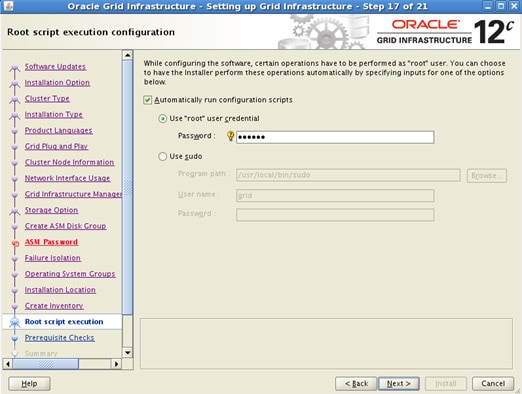

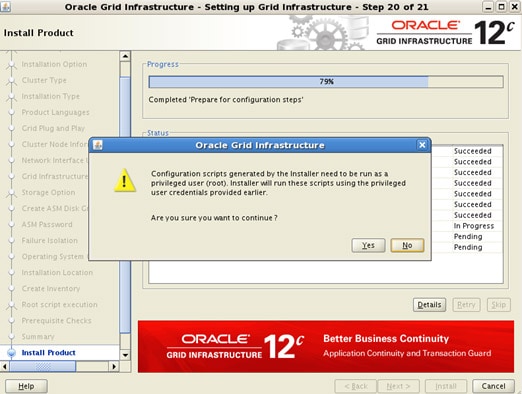

Novidade no 12cR1. Agora é possível informar a senha do usuário “root” para execução de scripts ao final do instalador

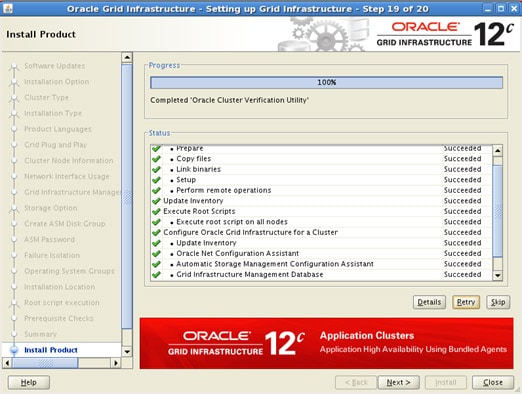

Checando os serviços do Grid Infrastructure

Status do Cluster:

# crsctl stat res -t

--------------------------------------------------------------------------------

Name Target State Server State details

--------------------------------------------------------------------------------

Local Resources

--------------------------------------------------------------------------------

ora.LISTENER.lsnr

ONLINE ONLINE racnode1 STABLE

ONLINE ONLINE racnode2 STABLE

ora.OCR.dg

ONLINE ONLINE racnode1 STABLE

ONLINE ONLINE racnode2 STABLE

ora.asm

ONLINE ONLINE racnode1 Started,STABLE

ONLINE ONLINE racnode2 Started,STABLE

ora.net1.network

ONLINE ONLINE racnode1 STABLE

ONLINE ONLINE racnode2 STABLE

ora.ons

ONLINE ONLINE racnode1 STABLE

ONLINE ONLINE racnode2 STABLE

--------------------------------------------------------------------------------

Cluster Resources

--------------------------------------------------------------------------------

ora.LISTENER_SCAN1.lsnr

1 ONLINE ONLINE racnode1 STABLE

ora.LISTENER_SCAN2.lsnr

1 ONLINE ONLINE racnode2 STABLE

ora.LISTENER_SCAN3.lsnr

1 ONLINE ONLINE racnode2 STABLE

ora.MGMTLSNR

1 ONLINE ONLINE racnode2 169.254.50.1610.11.

0.2 10.1.0.2,STABLE

ora.cvu

1 ONLINE ONLINE racnode2 STABLE

ora.mgmtdb

1 ONLINE ONLINE racnode2 Open,STABLE

ora.oc4j

1 ONLINE ONLINE racnode2 STABLE

ora.racnode1.vip

1 ONLINE ONLINE racnode1 STABLE

ora.racnode2.vip

1 ONLINE ONLINE racnode2 STABLE

ora.scan1.vip

1 ONLINE ONLINE racnode1 STABLE

ora.scan2.vip

1 ONLINE ONLINE racnode2 STABLE

ora.scan3.vip

1 ONLINE ONLINE racnode2 STABLE

--------------------------------------------------------------------------------

Status do Listener:

[grid@racnode1:/home/grid [+ASM1] ]$ lsnrctl stat

LSNRCTL for Linux: Version 12.1.0.1.0 - Production on 23-JUL-2013 12:21:15

Copyright (c) 1991, 2013, Oracle. All rights reserved.

Connecting to (DESCRIPTION=(ADDRESS=(PROTOCOL=IPC)(KEY=LISTENER)))

STATUS of the LISTENER

------------------------

Alias LISTENER

Version TNSLSNR for Linux: Version 12.1.0.1.0 - Production

Start Date 23-JUL-2013 12:17:15

Uptime 0 days 0 hr. 3 min. 59 sec

Trace Level off

Security ON: Local OS Authentication

SNMP OFF

Listener Parameter File /u01/app/12.1.0.1/grid/network/admin/listener.ora

Listener Log File /u01/app/oracle/diag/tnslsnr/racnode1/listener/alert/log.xml

Listening Endpoints Summary...

(DESCRIPTION=(ADDRESS=(PROTOCOL=ipc)(KEY=LISTENER)))

(DESCRIPTION=(ADDRESS=(PROTOCOL=tcp)(HOST=192.168.1.11)(PORT=1521)))

(DESCRIPTION=(ADDRESS=(PROTOCOL=tcp)(HOST=192.168.1.21)(PORT=1521)))

Services Summary...

Service "+ASM" has 1 instance(s).

Instance "+ASM1", status READY, has 1 handler(s) for this service...

The command completed successfully

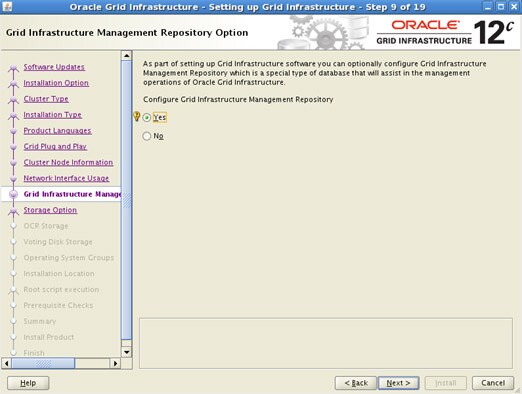

Grid Infrastructure Management Database

Na versão 12c foi criado um banco de dados exclusivamente para gerenciamento do Oracle Clusterware 12c. Este Database é configurado em modo Single Instance e é executado em apenas um node de um cluster. Caso este node seja indisponibilizado, o database será ativado em outro node do cluster.

Neste database é configurado um repositório para o CHM (Cluster Health Monitor) e outras informações do Clusterware 12c. Este database ainda utiliza o mesmo storage device onde está configurado o OCR e é gerenciado automaticamente pelo Oracle Grid Infrastructure.

Caso este recurso não seja ativado, o Cluster Health Monitor / OS não será ativado.

Na versão 11g, as informações do CHM ficam armazenadas no diretório$GRID_HOME/crf/db/hostname, e consequentemente utizam espaço em disco deste local.

Para configuração deste database, uma desvantagem é que o Diskgroup para o OCR/Voting precisa de no mínimo 4,5G, sendo assim (apesar de pequeno) é necessário mais disco para este.

Gerenciamento do MGMTDB

Para identificar qual node do cluster é o node master para o MGMTDB:

# oclumon manage -get MASTER Master = racnode1

Verificando via Server Control Utility (srvctl):

#srvctl status mgmtdb Database is enabled Instance -MGMTDB is running on node racnode1 #srvctl config mgmtdb Database unique name: _mgmtdb Database name: Oracle home: /u01/app/12.1.0.1/grid Oracle user: grid Spfile: +OCR/_mgmtdb/spfile-MGMTDB.ora Password file: Domain: Start options: open Stop options: immediate Database role: PRIMARY Management policy: AUTOMATIC Database instance: -MGMTDB Type: Management

Verificando Status e Datafiles do Database:

# ps -ef|grep pmon grid 5375 1 0 15:12 ? 00:00:00 asm_pmon_+ASM1 grid 5825 1 0 15:13 ? 00:00:00 mdb_pmon_-MGMTDB grid 10389 10363 0 15:37 pts/0 00:00:00 grep pmon # export ORACLE_SID=-MGMTDB # sqlplus / as sysdba SQL> select file_name from dba_data_files union select member file_name from V$logfile; FILE_NAME ------------------------------------------------------------------ +OCR/_MGMTDB/DATAFILE/sysaux.258.821044039 +OCR/_MGMTDB/DATAFILE/sysgridhomedata.261.821044155 +OCR/_MGMTDB/DATAFILE/sysmgmtdata.260.821044109 +OCR/_MGMTDB/DATAFILE/system.259.821044065 +OCR/_MGMTDB/DATAFILE/undotbs1.257.821044035 +OCR/_MGMTDB/ONLINELOG/group_1.263.821044189 +OCR/_MGMTDB/ONLINELOG/group_2.264.821044189 +OCR/_MGMTDB/ONLINELOG/group_3.265.821044191 8 rows selected.

Verificando local do CHM Repository:

# oclumon manage -get reppath CHM Repository Path = +OCR/_MGMTDB/DATAFILE/sysmgmtdata.260.821044109

Verificando o Tamanhodo CHM Repository:

SQL> select file_name, maxbytes, bytes from dba_data_files where file_name='+OCR/_MGMTDB/DATAFILE/sysmgmtdata.260.821044109'; FILE_NAME MAXBYTES BYTES ----------------------------------------------- -------- --------- +OCR/_MGMTDB/DATAFILE/sysmgmtdata.260.821044109 0 2147483648

Extendendo o Tamanho do CHM Repository: (Se necessário)

# oclumon manage -repos changerepossize 4000 The Cluster Health Monitor repository was successfully resized.The new retention is 266160 seconds. # sqlplus / as sysdba SQL> select file_name, maxbytes, bytes from dba_data_files where file_name='+OCR/_MGMTDB/DATAFILE/sysmgmtdata.260.821044109'; FILE_NAME MAXBYTES BYTES ----------------------------------------------- -------- --------- +OCR/_MGMTDB/DATAFILE/sysmgmtdata.260.821044109 0 4287586740

Reduzindo o Tamanho do CHM Repository: (Se necessário)

# oclumon manage -repos changerepossize 3000

Warning: Entire data in Cluster Health Monitor repository will be deleted.Do you want to continue(Yes/No)?

Yes

The Cluster Health Monitor repository was successfully resized.The new retention is 199620 seconds.

# sqlplus / as sysdba

SQL> select file_name, maxbytes, bytes from dba_data_files where file_name='+OCR/_MGMTDB/DATAFILE/sysmgmtdata.260.821044109';

FILE_NAME MAXBYTES BYTES

----------------------------------------------- -------- ---------

+OCR/_MGMTDB/DATAFILE/sysmgmtdata.260.821044109 0 3143244520

Mais informações sobre o commando oclumon podem ser obtidas em Oclumon Command Reference

Da mesma forma que qualquer outro database comum (isso iniciou a partir da versão 11g) os arquivos de Trace podem ser encontrados em:

# $ORACLE_BASE/ diag/rdbms/_mgmtdb/-MGMTDB/trace/

Para verificar se todos os usuários necessários para o correto funcionamento do CHM estão ok:

# sqlplus / as sysdba SQL> select username,account_status from dba_users where username like 'CH%'; USERNAME ACCOUNT_STATUS ---------- -------------------------------- CHM OPEN CHA OPEN

Victor Armbrust é DBA há 10 anos, especialista em Banco de Dados Oracle e Bacharel em Ciências da Computação. Com sólidos conhecimentos em Banco de Dados e Sistemas operacionais, possui certificações OCP 10g/11g. Eleito Oracle ACE Member em 2013. Consultor de Banco de Dados na Oracle ACS Brasil.

Entre em Contato Conosco

- Vendas: 0800-891-4433

- Contatos Globais

- Diretório de Suporte